新传理论 | 2025-02-11 16:49

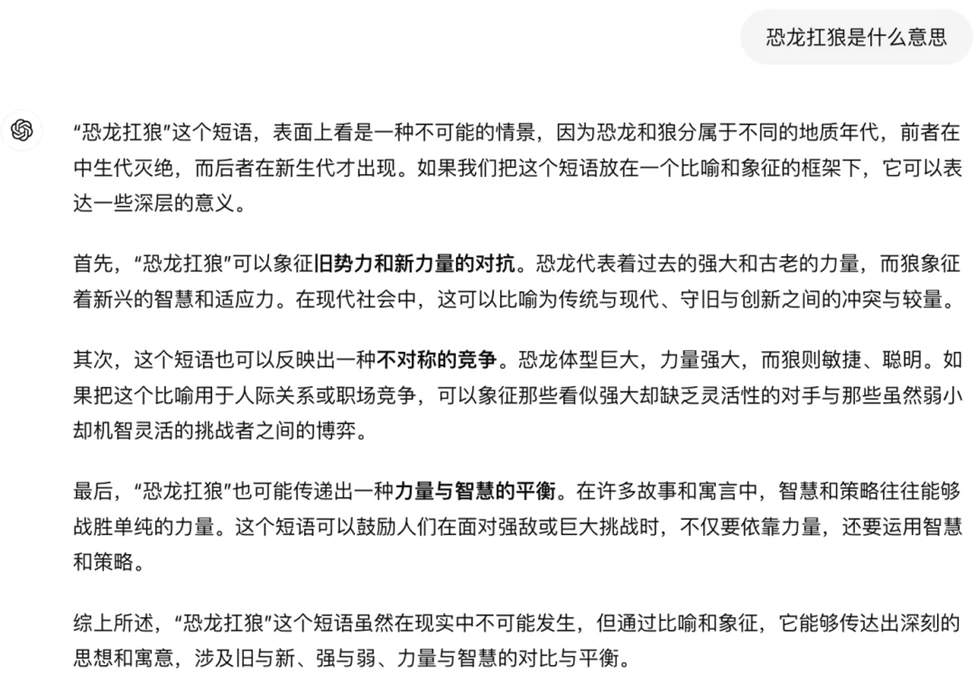

你是否有的时候觉得聊天机器人在回答问题时,答非所问?

甚至有的时候“已读乱回”,给人误导性信息?

今天给大家介绍的一个新传前沿名解——AI幻觉(AI Hallucinations)

01

定义

“AI幻觉”一词指的是人工智能模型生成的内容,不是基于任何现实世界的数据,而是模型自己想象的产物。就聊天机器人而言,幻觉指的是在原本正确的回答中加入不正确的信息,把错误的信息当作事实同正确的数据一起呈现,使人难以分辨其真假。正如OpenAI 首席执行官Sam Altman所说:“ChatGPT有很大的局限性,它确实知道很多东西,但危险的是,它在相当大的一部分时间里是自信而错误的”。

AI幻觉可以分为内在幻觉和外在幻觉两类。

内在幻觉是指AI生成的输出内容与输入内容不一致的幻觉内容。这种错误主要表现在AI模型给出的回答与用户的输入问题或对话历史上下文信息相矛盾。

外在幻觉是指AI生成的输出内容与世界知识不一致或是通过已有信息无法验证的内容。这种错误通常表现为AI模型针对用户提出的事实性问题给出错误回答,或编造无法验证的内容。

图:Ai幻觉的表现

02

特征与原因

AI幻觉的主要特征:

编造引用:AI可能会生成虚构的参考文献、DOI(数字对象识别符)或不存在的研究。

虚假陈述:AI在回答问题时可能会提供看似正确的答案,但这些信息实际上并没有依据或事实支持。

语义正确但内容错误:AI输出的句子在语法上是正确的,但其内容与真实情况不符。

AI幻觉的原因:

数据不足或偏差:AI模型的训练数据可能不足或存在偏差,导致它在不确定的情况下生成错误信息。

推理不准确:AI会根据训练过程中学到的模式进行推理,有时会“推测”答案,而非基于实际数据。

缺乏背景理解:AI无法真正理解背景和上下文,可能会错误地连接相关信息,从而导致幻觉。

03

经典研究

Exploring the boundaries of reality: investigating the phenomenon of artificial intelligence hallucination in scientific writing through ChatGPT

本文讨论了聊天机器人,特别是ChatGPT,利用人工智能(AI)和自然语言处理(NLP)来模拟与人类的对话。ChatGPT基于OpenAI的GPT-3引擎,尽管它在文本生成方面获得了关注,但其准确性、精确性及引用法律问题引发了担忧。本研究调查了ChatGPT在完全由其生成的研究提案中的AI幻觉(即错误数据生成)频率。分析了178个引用,其中许多缺少DOI(数字对象标识符),部分引用无法追踪或不正确,揭示了ChatGPT在提供可靠研究引用方面的局限性。研究结论认为,AI幻觉可能对决策产生负面影响,并引发伦理和法律问题。为解决这些问题,需要通过多样且准确的数据改进训练模型,但在此之前,研究人员应谨慎依赖ChatGPT生成的引用。

Siren's song in the AI ocean: a survey on hallucination in large language models

虽然大型语言模型 (LLM) 在一系列下游任务中表现出了卓越的能力,但人们担心它们容易产生幻觉:LLM 有时会生成与用户输入不同的内容、与之前生成的上下文相矛盾的内容或与既定的世界知识不一致的内容。这种现象对 LLM 在现实世界中的可靠性提出了巨大挑战。在本文中,我们调查了最近在检测、解释和缓解幻觉方面的努力,重点关注 LLM 带来的独特挑战。我们介绍了 LLM 幻觉现象的分类和评估基准,分析了旨在缓解 LLM 幻觉的现有方法,并讨论了未来研究的潜在方向。

AI hallucination: towards a comprehensive classification of distorted information in artificial intelligence-generated content

在蓬勃发展的信息时代,人工智能生成内容(AIGC)的快速发展带来了信息真实性方面的挑战。失真信息的泛滥给用户带来了极大的负面影响。本研究旨在对人工智能生成内容(AIGC)中的失真信息进行系统分类,深入探讨其内在特征,并为其管理提供理论指导。我们以 ChatGPT 为案例,对收集到的 243 条失真信息(包括问题和答案)进行了实证内容分析。

三名编码员对每个失真信息实例进行了细致的解读,根据预定义的编码方案对错误点进行编码,并根据错误类型对其进行分类。我们的目标是通过多轮预编码和测试编码,完善和验证审查得出的失真信息类别列表,从而得出一份全面、清晰的 AIGC 失真信息类别列表。研究结果确定了 8 种一级错误类型:“过度拟合“、”逻辑错误“、”推理错误“、”数学错误“、”毫无根据的捏造“、”事实错误“、”文本输出错误 “和 ”其他错误 "8 个一级错误类型,并进一步细分为 31 个二级错误类型。这一分类列表不仅为研究与 AIGC 相关的风险奠定了坚实的基础,而且对于帮助用户识别失真信息和使开发人员提高人工智能生成工具的质量也具有重要的实际意义。

参考文献:

[1]科学传播|AI幻觉:为什么ChatGPT有时会一本正经地胡说八道https://mp.weixin.qq.com/s/xk5LbFCe-cYtJ58RWL-wSQ

[2]Athaluri, S. A., Manthena, S. V., Kesapragada, V. K. M., Yarlagadda, V., Dave, T., & Duddumpudi, R. T. S. (2023). Exploring the boundaries of reality: investigating the phenomenon of artificial intelligence hallucination in scientific writing through ChatGPT references. Cureus, 15(4).

[3] Zhang, Y., Li, Y., Cui, L., Cai, D., Liu, L., Fu, T., ... & Shi, S. (2023). Siren's song in the AI ocean: a survey on hallucination in large language models. arXiv preprint arXiv:2309.01219.

[4] Sun, Y., Sheng, D., Zhou, Z., & Wu, Y. (2024). AI hallucination: towards a comprehensive classification of distorted information in artificial intelligence-generated content. Humanities and Social Sciences Communications, 11(1), 1-14.

在线咨询

在线咨询

联系电话

联系电话

微信咨询

微信咨询